티스토리 뷰

반응형

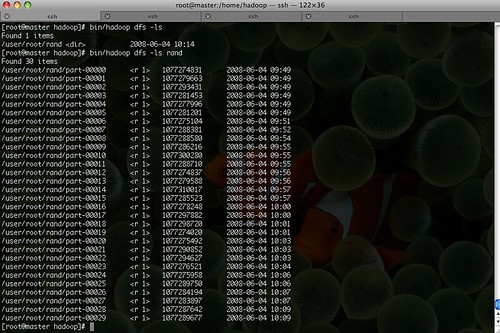

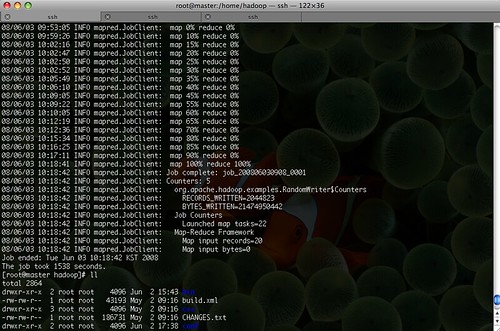

어제 오늘 Hadoop Cluster를 설정을 하고는 MapReduce 예제들을 돌려보고 있다.(jetty 웹서버가 인터넷에 연결이 되지 않으면 뭔 j2ee 네임스페이스를 찾을 수 없다고 에러를 내는 바람에 이거 찾느라고 어제 하루는 다 보내 버렸다.) 우선 RandomWriter를 통해서 30GB의 입력데이터로 사용할 데이터를 생성했다. 1GB씩 총 30개가 생성되었다.

총 1538초 약 26분정도의 시간이 소요되었다.(테스트는 총 3대의 DataNode에서 수행,,)

총 1538초 약 26분정도의 시간이 소요되었다.(테스트는 총 3대의 DataNode에서 수행,,)

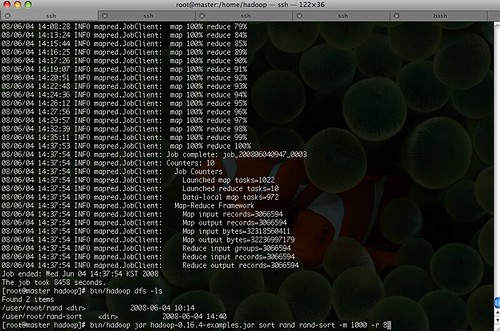

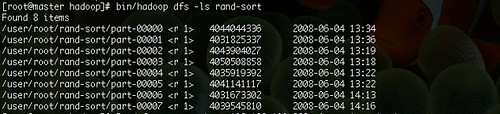

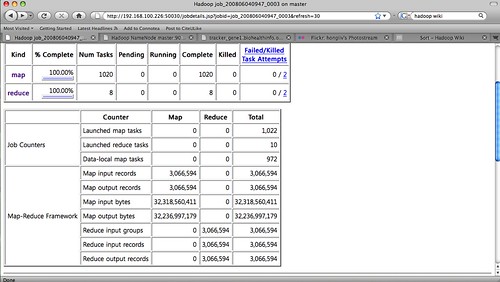

이 입력데이터를 가지고 역시 예제 Sort를 수행하였다. 처음에는 Map과 Reduce의 갯수를 지정하지 않고 다음과 같이 기본 명령만을 주고 수행하였다.

$ bin/haddop jar hadoop-*-example.jar sort rand rand-sort

결과는 outofmemory를 중간중간 내뱉다가는 결국에는 fail이 나고 말았다. 하둡의 퍼포먼스(삽질기)를 보고는 Map의 갯수를 1,000개 Reduce 갯수를 8로 주고 다시 실행해 보았다.

$ bin/haddop jar hadoop-*-example.jar sort rand rand-sort

결과는 outofmemory를 중간중간 내뱉다가는 결국에는 fail이 나고 말았다. 하둡의 퍼포먼스(삽질기)를 보고는 Map의 갯수를 1,000개 Reduce 갯수를 8로 주고 다시 실행해 보았다.

반응형

공지사항

최근에 올라온 글